Informatik Wie Maschinen das Lernen lernen

Kinder lernen täglich hinzu, weil sie ständig Fragen stellen und neugierig ihre Umgebung erkunden. Können auch Maschinen mit künstlicher Intelligenz auf diese Art und Weise lernen? Und falls ja, welche Schlüsselkompetenzen muss eine intelligente Maschine dafür besitzen? Das erforscht Alexander Freytag.

Mama, warum wird es nachts dunkel?“, „Papa, wieso hat das Zebra Streifen?“ – Eltern kennen diese Fragen und wissen, wie wichtig Neugier für die kindliche Entwicklung ist. Das zielgerichtete Erforschen von Neuem, das Stellen von Fragen und das Verarbeiten von Antworten begleiten uns aber ein Leben lang – „man lernt niemals aus“, heißt es ja zu Recht. Doch was wäre, wenn uns nicht nur unsere Kinder mit Fragen löcherten, sondern auch all die „intelligenten“ Helfer im Alltag? Wenn das Auto, der Saugroboter oder das Smartphone plötzlich anfingen zu lernen?

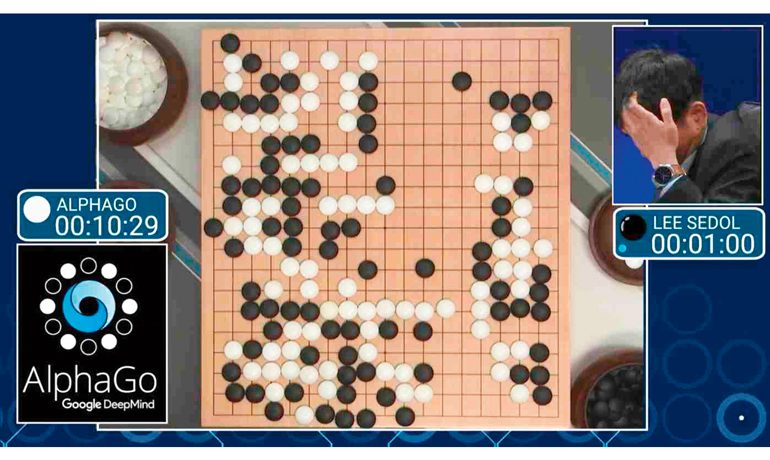

Zweifellos beeinflusst der technologische Fortschritt in den Forschungsbereichen des Maschinellen Lernens (ML) und der Künstlichen Intelligenz (KI) maßgeblich unsere Gesellschaft. Das vollkommen autonom fahrende Auto ist keine Zukunftsvision mehr, längst gibt es auch intelligente Programme, die Ärzten helfen, bei ihrer Diagnose die richtigen Fragen zu stellen, und wir alle haben schon mit unseren Smartphones gesprochen. Um die hohen Ansprüche an Genauigkeit und Verlässlichkeit erfüllen zu können, benötigen solche Assistenten jedoch – genau wie wir Menschen – einen möglichst großen „Erfahrungsschatz“, um daraus zu lernen.

Tatsächlich haben die derzeitigen Verfahren des Maschinellen Lernens bereits einiges mit unserem menschlichen Gehirn gemeinsam. Bei unserer Geburt sind bereits alle Neuronen vorhanden. Im Zuge des Lernens werden die bestehenden Verbindungen zwischen diesen Neuronen dicker oder dünner, um Informationen effektiv verarbeiten zu können. Nach dem gleichen Prinzip werden auch die „Baupläne“ von aktuellen ML-Verfahren programmiert (zum Beispiel die „Anzahl der Neuronen“ vorgegeben), die Einstellungen für deren „Stellschrauben“ jedoch aus Trainingsdaten gelernt.

Im Gegensatz zu diesem statischen Design steht unsere menschliche Fähigkeit, kontinuierlich Wissen zu akkumulieren, um sich ändernden Umgebungen gerecht zu werden. Deshalb können wir in Windeseile eine Treppe hinauflaufen, im nächsten Moment einen Apfel schälen und im Anschluss mit unserem Auto in die Stadt fahren. Und sollten wir einmal nicht weiterwissen, können wir Fragen stellen. Ein Computer, der all dies beherrscht, ist noch undenkbar. Dafür ist er in der Lage, in Millisekunden sechsstellige Zahlen zu multiplizieren.

Noch ist das Lernen von Mensch und Maschine jedoch nur ansatzweise vergleichbar. Im Gegensatz zu unseren neugierigen Kindern sind die aktuellen ML-Lösungen nämlich statisch konzipiert, werden also nur einmal mit vielen Lernbeispielen „gefüttert“. Später lernen sie nichts Neues hinzu. Als Beispiel sei die Gesichtserkennung von Kameras genannt, welche einmal das Aussehen von Gesichtern lernt und dann diesen Algorithmus immer wieder verwendet.

Noch ist das Lernen von Mensch und Maschine nur ansatzweise vergleichbar.

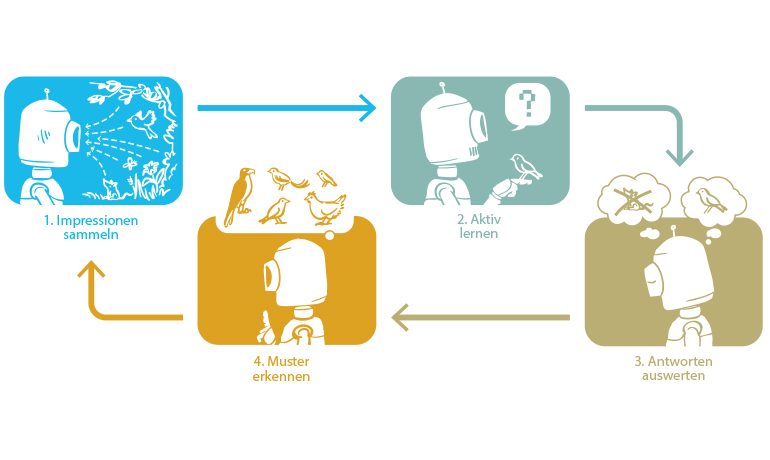

Derzeit können wir Computer allenfalls mit einzelnen Aspekten unserer Fähigkeiten ausstatten. In meiner Dissertation wählte ich zusammen mit Kollegen der Friedrich-Schiller-Universität Jena und der University of California, Berkeley vier dieser Fähigkeiten aus: (1) die Verarbeitung von hunderttausenden Eindrücken, (2) das kontinuierliche Lernen, (3) das aktive Lernen sowie (4) das Erkennen von Mustern und Merkmalen (siehe Bild oben). In meiner Arbeit präsentierte ich, wie sich diese vier Aspekte ergänzen können und zusammen den „Kreislauf des lebenslangen Lernens“ ergeben.

Für die Verarbeitung von hundertausenden Eindrücken, also das Lernen aus großen Datenmengen, untersuchte ich sogenannte Gauss-Prozess-Modelle. Diese zeichnen sich durch eine Reihe von Vorteilen aus, allerdings benötigt eine Maschine vergleichsweise viel Zeit und Speicher, um alle notwendigen Operationen dieser Modelle durchzuführen. Die Folge: Speicher und Prozessoren sind selbst bei statischen Systemen rasch ausgelastet.

Ich entwickelte daher ein numerisches Verfahren, welches mit deutlich weniger Aufwand zum gleichen Ergebnis gelangt. Dadurch wird sowohl die nötige Rechenzeit als auch deren Abhängigkeit von der Datenmenge massiv reduziert. Die Lernphase dieser Modelle ist schon nach wenigen Sekunden abgeschlossen, und die Bearbeitung neuer Eindrücke kann in Millisekunden erfolgen – eine klare Zeitersparnis gegenüber der viele Minuten dauernden herkömmlichen Methode. Zudem konnte der Speicherbedarf reduziert werden, wodurch Kosten für teure Highend-Hardware unnötig wurden.

Um diese Verfahren für kontinuierlich lernende Systeme tatsächlich nutzen zu können, waren zusätzliche Erweiterungen nötig, damit ständig hinzukommende Daten (Erfahrungen) verarbeitet werden können. Als Vorbild kann dabei der menschliche Schlaf dienen, in dem wir die Eindrücke des Tages verarbeiten und Erlebnisse in Erinnerungen umwandeln. Nun ist dies ein höchst komplexer und noch lange nicht verstandener Prozess. Deshalb entwickelten wir für verschiedene Herausforderungen unterschiedliche „Schlafmodi“ – und waren so in der Lage, große und wachsende Datenmengen in regelmäßigen Abständen zu verarbeiten.

Eine Maschine, die permanent nachfragt, ist unpraktikabel, eine, die sich stets auf Intuition verlässt, aber auch.

Im nächsten Schritt versuchten wir uns an der Umsetzung des aktiven Lernens. Die Maschine soll aus großen Datensammlungen gezielt nur jene Elemente auswählen, für die eine Frage nach dem Inhalt „viel neues Wissen verspricht“. Eine solche Datensammlung kann etwa alle Eindrücke eines Tages beinhalten.

Doch diese Unterscheidung von Wichtigem und Unwichtigem, die Frage, welche Informationen ich schon habe und wie ich etwas daraus mache, ist alles andere als trivial. Eine Maschine, die permanent nachfragt, ist unpraktikabel, eine, die sich stets auf Intuition verlässt, aber auch. Daher verfolgen die meisten existierenden Ansätze entweder Heuristiken, das heißt sie kommen mit begrenztem Wissen zu einer mehr oder weniger plausiblen Lösung. Oder sie „denken enorm lange nach“, bevor sie eine Frage stellen.

Heuristiken haben den Nachteil, dass die Lösung eben doch nicht immer die richtige ist und die Maschine in die falsche Richtung „denkt“ und fragt. Ein zu langes Nachdenken hingegen macht einen Dialog unmöglich. In meiner Promotion entwickelte ich daher neue Verfahren, welche schnell berechenbar sind (also eine schnelle Frage-Antwort-Zeit zulassen) und trotzdem eine theoretische Verbindung zur erwarteten Informationsmaximierung aufweisen.

Mit den bisher vorgestellten „Fähigkeiten“ können Maschinen mit großen Datenmengen umgehen, neu hinzukommende Eindrücke verarbeiten und gegebenenfalls aktiv nach deren Inhalt fragen. Aber wie kann eine Maschine feststellen, was ein neues Objekt einzigartig macht, um es später wiederzuerkennen? Unseren Kindern geben wir häufig Hilfestellungen, wie etwa „Das ist eine Giraffe – sie hat einen langen Hals und ist gefleckt“. Wir geben also nicht nur die Antwort auf die Frage „Was ist das?“, sondern begründen unsere Antwort mit Entscheidungshilfen.

Es ist jedoch alles andere als einfach, solche Hinweise auch einer Maschine verständlich zu erklären. Ein Ausweg kann daher sein, dass die Maschine visuelle Besonderheiten von neuen Objekten automatisch erkennt. Im letzten Beitrag meiner Arbeit entwickelte ich ein solches Verfahren, mit dem intelligente Maschinen Objekte anhand relevanter Muster und Merkmale erkennen und diese Merkmale bei Bedarf sogar automatisiert ergänzen. Besonders in Szenarien der automatisierten Tierbeobachtung mit Kamerafallen haben diese Techniken großes Potenzial, um etwa Vogelarten zu unterscheiden und Statistiken über deren Lebensräume zu erstellen.

Die Kombination der hier beschriebenen „Fähigkeiten“ könnte zukünftig die Grundlage intelligenter Maschinen sein, die im Kreislauf des lebenslangen Lernens stetig besser werden: Impressionen wahrnehmen – Fragen stellen – Antworten auswerten – Wissen aktualisieren – Impressionen wahrnehmen – und so weiter. Die Einsatzmöglichkeiten sind nahezu unbegrenzt: von autonomen lernenden Fahrzeugen über intelligente Haustierroboter bis hin zu lernenden Maschinen, die das Weltall erforschen. Wir dürfen gespannt sein, welche Anwendungen wir in den nächsten Jahren und Jahrzehnten erleben werden.

Und noch etwas ist völlig unklar. Wenn es wirklich einmal Maschinen geben sollte, die wie wir lernen und eigenmächtig Schlüsse ziehen, stellen sich völlig neue ethische Fragen. Wer haftet, wenn ein Computer falsche Entscheidungen trifft? Kann er überhaupt nach moralischen Kriterien handeln? Was passiert, wenn wir die Fragen der Maschine so beantworten, dass sie sich gegen Mitmenschen richtet? Am Ende müssen wir überlegen, ob lernende Systeme eine eigene Rechtsprechung benötigen. Das alles hört sich momentan noch an wie Science-Fiction. Doch im Rahmen meiner Doktorarbeit konnte ich zeigen, dass einzelne Aspekte unserer Art des lebenslangen Lernens für Maschinen durchaus sowohl theoretisch als auch praktisch realisierbar sind. Wie wir mit diesem Wissen umgehen, werden wir erst lernen müssen.

Hintergrund

Die dritte Blüte

Evolution der künstlichen Intelligenz

Seit Jahrhunderten versuchen Menschen, künstliches Leben zu schaffen. Im Barock gab es Puppen, die Liebesbriefe schrieben; 1738 baute der französische Erfinder Jacques de Vaucanson eine mechanische Ente, die, so schien es, Körner fressen und verdauen konnte.

Im 20. Jahrhundert rückte das Gehirn ins Blickfeld. Allmählich begann man zu verstehen, dass das Denken auf elektrischen Impulsen beruht. Das Gehirn, nichts als ein elektrischer Rechner?

1958 entwarf Frank Rosenblatt das Perceptron, ein erstes „neuronales Netz“, ein lernfähiges Netzwerk mit Nerven aus Draht. Doch selbst die größten „Elektronengehirne“ der 1960er- und 1970er-Jahre konnten kaum runde von eckigen Bauklötzen unterscheiden. Erst die rasant wachsende Mathematik stellte zahlreiche neue Methoden zur Verfügung, mit denen sich ebenfalls so etwas wie intelligentes Verhalten simulieren lässt. Dafür reicht es, wenn Algorithmen aus der Vergangenheit lernen, in Zukunft Daten korrekt zu klassifizieren – und womöglich die Entscheidungen mit der Zeit anpassen, so dass die Fehler immer weniger werden.

Gleichzeitig wurden Rechenleistung und Speicherplatz immer billiger – und die neuronalen Netze wieder aus den Schubladen geholt. Ende der 1980er-Jahre entwickelte der Informatiker Yann LeCun sie weiter: Mit seinen neuartigen Methoden begannen Computer Ende der 1990er-Jahre damit, Handschriften auf Briefumschlägen zu erkennen.

Doch während Hard- und Software exponentiell leistungsfähiger wurden, tauchte ein neues Problem auf: „Rohstoffknappheit“. Um zu lernen, Gesichter oder Zahlen von Buchstaben zu unterscheiden, brauchen die neuronalen Netze tausende Fotos. Die Algorithmen hungerten nach Daten, die erst das Internet in Hülle und Fülle lieferte.

Heute erleben wir die dritte Blüte der künstlichen Intelligenz, angetrieben durch Rechenleistung, schnelle Algorithmen und vor allem: klassifizierte Daten. Kein Wunder, dass Konzerne wie Apple und Google – Hüter gigantischer Datenschätze – treibende Kräfte beim Wachstum der künstlichen Intelligenz sind.

von Andreas Loos